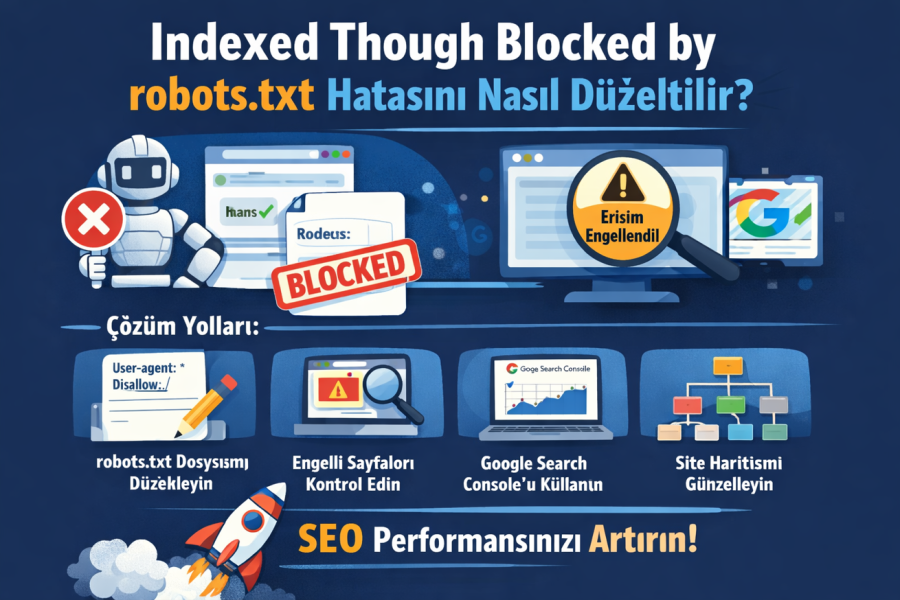

Indexed Though Blocked by robots.txt hatası sitenizin sıralamalarını düşürüyor olabilir. Bu sorunu çözmenin pratik yollarını ve nedenlerini öğrenin.

Web sitenizin Google sıralamasında yaşadığınız düşüş sizi endişelendiriyor mu? Belki de Google Search Console’da Indexed Though Blocked by robots.txt uyarısıyla karşılaştınız ve ne yapacağınızı bilemiyorsunuz. Bu durum aslında birçok site sahibinin yaşadığı yaygın bir sorun. İyi haber şu ki çözümü düşündüğünüz kadar karmaşık değil.

Sitenizin arama motorlarında doğru şekilde görünmesi, ziyaretçi sayınızı ve dolayısıyla dönüşümlerinizi doğrudan etkiliyor. Indexed Though Blocked by robots.txt hatası tam olarak bu noktada devreye giriyor ve sayfalarınızın Google tarafından düzgün taranmasını engelliyor. Peki bu hata neden oluşuyor ve nasıl düzeltebilirsiniz? Hemen açıklayalım.

Indexed Though Blocked by robots.txt Hatası Nedir?

Google’ın sayfanızı bulup dizine eklediğini ama aynı zamanda robots.txt dosyanızda bir engelle karşılaştığını gösteren bir uyarıdır bu. Basitçe söylemek gerekirse Google size şunu diyor: Senin sayfanı buldum ama robots.txt dosyan bana bu sayfayı taramamı söylüyor. Ne yapmamı istiyorsun?

Robots.txt Dosyası Ne İşe Yarar?

Robots.txt dosyası, arama motoru robotlarına hangi sayfaların taranabileceğini söyleyen bir yol haritası gibidir. Web sitenizin kök dizininde bulunan bu dosya sayesinde önemli sayfalarınızın taranmasını sağlarken, gereksiz dosyaların Google’ın dikkatini dağıtmasını engellersiniz.

Ancak bu dosyayı yanlış yapılandırırsanız işte o zaman bu sorunla karşılaşırsınız. Google sayfayı dizine eklemiş olabilir ama içeriğini gösteremiyor. Arama sonuçlarında sayfa başlığı görünür ancak açıklama metni, görseller veya PDF’ler eksik kalır.

Hatanın Ortaya Çıkma Nedenleri

Hatanın sebepleri arasında birkaç temel faktör öne çıkıyor. Başka bir site sizin engellediğiniz sayfaya link vermişse Google o sayfayı yine de dizine ekleyebilir. Bu durumda robots.txt engeliniz tam anlamıyla işe yaramaz.

Bazı durumlarda ise siz bilerek belirli sayfaları engellemişsinizdir. Admin paneli, giriş sayfaları veya teşekkür sayfaları gibi bölümleri zaten taratmak istemezsiniz. Ama dışarıdan gelen linkler bu sayfaların dizine girmesine neden olabilir.

Hangi sayfaların taranması gerektiğini, hangilerinin gerekmediğini bilmek kritik öneme sahip. Aksi takdirde sunucunuz gereksiz yere yorulur ve Google değersiz sayfaları tararken asıl önemli içeriğinizi gözden kaçırabilir.

Hatayı Nasıl Tespit Edersiniz?

Google Search Console’a giriş yaptıktan sonra soldaki menüden Dizin bölümüne tıklayın. Burada Uyarılarla Geçerli sekmesini açtığınızda Though Blocked by robots.txt uyarısını görebilirsiniz. Eğer böyle bir uyarı yoksa sitenizde bu sorun yaşanmıyor demektir.

Robots.txt Dosyanızı Kontrol Edin

Alan adınızın sonuna /robots.txt ekleyerek doğrudan dosyanıza ulaşabilirsiniz. Örneğin siteadi.com/robots.txt şeklinde. Burada Disallow ifadelerini arayın. Eğer şöyle bir satır görürseniz tüm sayfalarınız engellenmiş olabilir:

Disallow: /

Google Search Console’daki robots.txt test aracını da kullanabilirsiniz. Bu araç sayesinde belirli bir URL’nin engellenip engellenmediğini test edebilir ve dosyanızdaki söz dizimi hatalarını tespit edebilirsiniz.

Bir sonraki adımda bu hatayı nasıl düzelteceğinizi göreceğiz.

Hatayı Düzeltme Yöntemleri

Hatayı tespit ettikten sonra sıra düzeltmeye gelir. İki temel yöntem var ve hangisini seçeceğiniz sitenizin yapısına bağlı.

Robots.txt Dosyasını Doğrudan Düzenleme

WordPress kullanıyorsanız muhtemelen sanal bir robots.txt dosyanız vardır. Ancak bunu düzenlemek için sunucunuzda fiziksel bir dosya oluşturmanız gerekir.

İlk olarak bir metin editöründe yeni bir dosya açın ve adını robots.txt koyun. Sonra bir SFTP istemcisi kullanarak hosting hesabınıza bağlanın. FileZilla gibi ücretsiz programları tercih edebilirsiniz.

Bağlantı bilgilerinizi girdikten sonra robots.txt dosyasını kök dizine yükleyin. WordPress siteler için bu dizin genelde public_html olarak adlandırılır. Dosyayı açtığınızda Allow ve Disallow ifadeleriyle sayfa tarama ayarlarınızı özelleştirebilirsiniz.

Örneğin wp-admin klasörünü engellerken belirli bir dosyaya izin vermek isterseniz şu kodu kullanabilirsiniz:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

Indexed Though Blocked by robots.txt hatasına neden olan sayfayı hedefleyerek gerekli değişiklikleri yapın. Amacınıza göre Google’ın o sayfayı taramasını sağlayabilir veya engellemeye devam edebilirsiniz.

SEO Eklentisi Kullanma

Eğer sitenizde Yoast SEO, Rank Math veya Squirrly SEO gibi bir eklenti aktifse işiniz çok daha kolay. Bu eklentiler robots.txt dosyasını sizin için oluşturur ve WordPress kontrol panelinden düzenleme imkanı sunar.

Yoast SEO ile Düzenleme

WordPress panonuzda Yoast SEO menüsüne girin ve Araçlar bölümünden Dosya Düzenleyici’yi seçin. Eğer robots.txt dosyanız yoksa Robots.txt Dosyası Oluştur butonuna tıklayın. Açılan editörde Allow ve Disallow ifadelerini ekleyerek sayfalarınızın taranma kurallarını belirleyin.

Değişikliklerinizi kaydettikten sonra Yoast SEO sizi bilgilendirecektir. Bu yöntemi kullanırken Indexed Though Blocked by robots.txt sorununa yol açan sayfaları dikkatle belirlemeyi unutmayın.

Rank Math Alternatifi

Rank Math kullanıyorsanız Genel Ayarlar bölümünden robots.txt düzenleyiciye ulaşabilirsiniz. Burada varsayılan kurallarınızı görecek ve gerekli kod değişikliklerini yapabileceksiniz.

Önemli bir nokta: Kök dizininizde halihazırda bir robots.txt dosyası varsa Rank Math editörü çalışmaz. Bu durumda ya SFTP ile dosyayı düzenlersiniz ya da mevcut dosyayı silip Rank Math’i kullanırsınız.

Rank Math’te bir sayfayı engellemenin yanı sıra noindex direktifi de eklemelisiniz. Başlıklar ve Meta bölümünden ilgili sayfa türü için No Index seçeneğini aktif edin. Böylece sayfa tamamen Google aramalarından gizlenmiş olur.

Siz bu yöntemleri denediniz mi? Hangi eklentiyi tercih ediyorsunuz?

Düzeltme Sonrası Yapmanız Gerekenler

Değişikliklerinizi yaptıktan sonra Google Search Console’a dönün. Indexed Though Blocked by robots.txt uyarısını bulup yanındaki Düzeltmeyi Doğrula butonuna tıklayın. Bu işlem Google’ın ilgili URL’leri yeniden taramasını ve hatayı çözmesini sağlar.

Sonuçları görmek birkaç gün sürebilir. Sabırlı olun ve düzenli olarak Search Console’u kontrol edin. Eğer hata devam ediyorsa robots.txt dosyanızı tekrar gözden geçirin veya farklı bir yöntem deneyin.

Sık Yapılan Hatalar

Bazı site sahipleri tüm siteyi yanlışlıkla engelleyebiliyor. Disallow: / ifadesi tüm sayfalarınızı taramadan çıkarır, buna dikkat edin. Ayrıca dış linkler yüzünden bu sorunu yaşıyorsanız sadece robots.txt düzenlemesi yetmeyebilir, noindex etiketi de eklemeniz gerekir.

Bu hata sitenizin SEO performansını olumsuz etkilese de çözümü elinizin altında. Doğrudan düzenleme veya SEO eklentisi kullanarak robots.txt dosyanızı kolayca yapılandırabilirsiniz.

WordPress sitenizde robots.txt hatası dışında başka sorunlarla da karşılaşabilirsiniz. 404 hataları, beyaz ekran sorunu, maksimum yürütme süresi aşımı gibi yaygın WordPress hataları sitenizin performansını ve kullanıcı deneyimini olumsuz etkileyebilir. Bu tür teknik sorunlarla karşılaştığınızda doğru tanı koymak ve hızlı çözüm üretmek önemlidir. En Yaygın WordPress Hatalarını Düzeltme ve Sorun Giderme İçin Nihai Kılavuz makalemizde WordPress’te karşılaşabileceğiniz diğer tüm hataları detaylı bir şekilde ele aldık. SEO hatalarınızı çözdükten sonra sitenizin genel sağlığını kontrol etmek için bu rehbere göz atmanızı öneririz.

Hangi yöntemi seçerseniz seçin amacınız açık olmalı: Google’a hangi sayfaların önemli olduğunu net bir şekilde göstermek. Allow ve Disallow ifadeleriyle bu kontrolü elinize alırsınız. Bu yöntemleri uygulayarak sonuçları gözlemleyin ve sitenizin arama motorlarındaki performansını artırın. Eğer teknik konularda destek almak isterseniz profesyonel yardım almanızı öneririz.